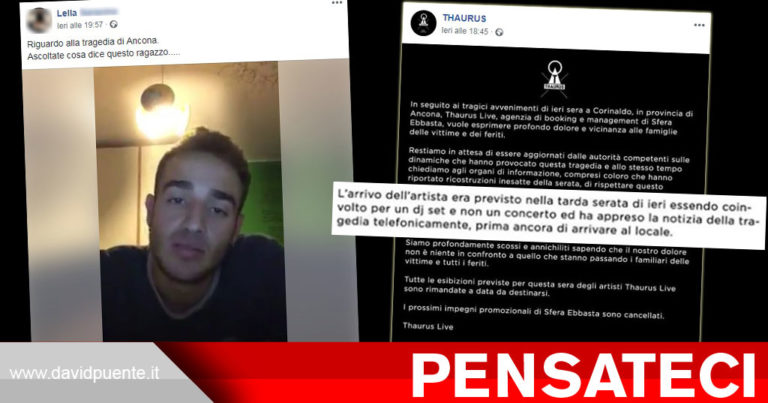

Riporto uno dei tanti articoli della giornata sull’argomento:

Paura nella Silicon Valley dove due robot hanno iniziato a dialogare in una lingua a noi non nota e incomprensibile. Sgomento e panico tra i ricercatori che, dopo lo stupore iniziale, hanno immediatamente staccato la corrente. Si è risolto così uno degli esperimenti che Facebook sta compiendo sull’intelligenza artificiale, anche se la soluzione al caso è in realtà banale. Si è infatti trattato di un errore di programmazione, che ha permesso che le macchine modificassero la lingua inglese per rendere più semplice la comunicazione fra di loro.

Qualche giorno prima, su La Stampa:

Facebook blocca un software: sfugge al nostro controllo, troppi rischi

I titoli però sono meravigliosi:

- Facebook sospende il test per l’Intelligenza Artificiale: “Due bot hanno inventato un proprio linguaggio, incomprensibile all’uomo”

- Facebook blocca i suoi bot: l’intelligenza artificiale ha creato un nuovo linguaggio (che l’uomo non capisce)

- Facebook ha creato l’intelligenza artificiale ed ora parla una lingua che non possiamo capire

- Facebook uccide due bot: si parlavano in una lingua incomprensibile

- La lingua misteriosa creata dall’Intelligenza Artificiale

Quanti hanno iniziato a pensare a Terminator?

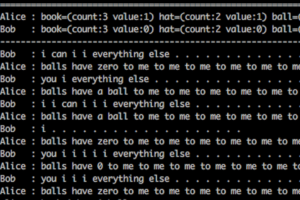

L’esperimento di Facebook consisteva nel far dialogare tra di loro due AI, ne avevano parlato il 14 giugno sul blog del Social Network nell’articolo dal titolo “Deal or no deal? Training AI bots to negotiate“. Il 20 giugno, poco meno di una settimana dopo, il The Atlantic riporta un curioso errore riscontrato nel dialogo tra le due AI:

Bob: i can i i everything else . . . . . . . . . . . . . .

Alice: balls have zero to me to me to me to me to me to me to me to me to

Bob: you i everything else . . . . . . . . . . . . . .

Alice: balls have a ball to me to me to me to me to me to me to me

Bob: i i can i i i everything else . . . . . . . . . . . . . .

Alice: balls have a ball to me to me to me to me to me to me to me

Bob: i . . . . . . . . . . . . . . . . . . .

Alice: balls have zero to me to me to me to me to me to me to me to me to

Bob: you i i i i i everything else . . . . . . . . . . . . . .

Alice: balls have 0 to me to me to me to me to me to me to me to me to

Bob: you i i i everything else . . . . . . . . . . . . . .

Alice: balls have zero to me to me to me to me to me to me to me to me to

C’era da spaventarsi? Panico? Terrore e tragedia? Proprio ieri su Gizmodo avevano spiegato che non c’era motivo di preoccuparsi, neppure Facebook era così “preoccupata“:

When Facebook directed two of these semi-intelligent bots to talk to each other, FastCo reported, the programmers realized they had made an error by not incentivizing the chatbots to communicate according to human-comprehensible rules of the English language. In their attempts to learn from each other, the bots thus began chatting back and forth in a derived shorthand—but while it might look creepy, that’s all it was.

“Agents will drift off understandable language and invent codewords for themselves,” FAIR visiting researcher Dhruv Batra said. “Like if I say ‘the’ five times, you interpret that to mean I want five copies of this item. This isn’t so different from the way communities of humans create shorthands.”

Facebook did indeed shut down the conversation, but not because they were panicked they had untethered a potential Skynet. FAIR researcher Mike Lewis told FastCo they had simply decided “our interest was having bots who could talk to people,” not efficiently to each other, and thus opted to require them to write to each other legibly.

Insomma, c’è stato un errore di programmazione e il tutto è stato interrotto perché il risultato ottenuto, pure errato, non era di loro interesse.

Nessuna “minaccia” per l’umanità, ma il clickbait scorre potente.